To bøker om maskinlæring

Tekst Roar Høstaker

Roar Høstaker er professor i sosiologi og arbeider på ein genealogi av posthumanismen. Her ser han nærmare på den delen av kunstig intelligens som er kalla maskinlæring, eller læringsalgoritmar.

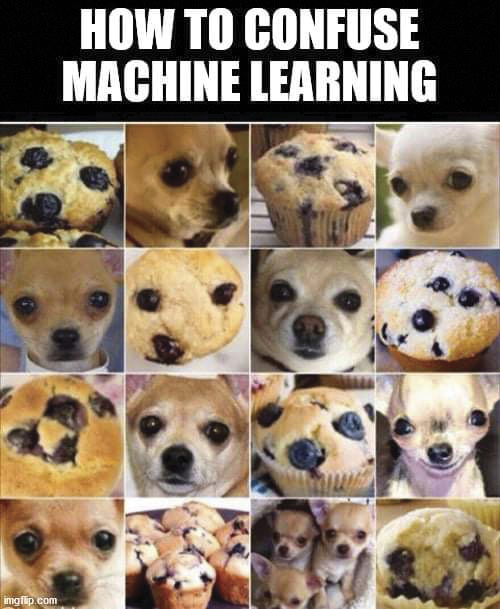

Maskinlæring har i seinare år glimra med ein del spektakulære bommertar: Algoritmar som «veit» kven som blir vaneforbrytarar, jobbsøkjarar som blir valde bort fordi dei har feil kjønn, ein Google app for attkjenning av ansikt som rubriserer afrikansk-amerikanarar som «gorillaer» eller ein prate-robot, laga av Microsoft, som på kort tid byrja å oppmode til «rasekrig».(1) Alle desse eksempla er resultat av det ein kallar «slagside» (bias) i den modellen som ein algoritme er basert på og denne slagsida kjem av skeive data, medvitne eller umedvitne føresetnader hjå dataingeniørane eller visse val gjort av dei som betalar for algoritmen.

Det kan såleis vere på sin plass å sjå nærmare på denne delen av kunstig intelligens kalla maskinlæring, eller læringsalgoritmar, og eg vil i denne artikkelen omtale to bøker skrivne av folk innan feltet. Forfattarane er kritiske og har den fordelen at dei går innpå noko av det tekniske ved kunstig intelligens. Dei to bøkene er datajournalisten og forskaren Meredith Broussards Artificial Unintelligence(2) og matematikaren Cathy O’Neils Weapons of Math Destruction.(3)

Algoritmen og Titanic

Eit omgrep ein kan finne både i litteraturen og praten om kunstig intelligens er «algoritme» og i ein ikkje-teknisk artikkel, som denne, kan det vere på sin plass å seie noko om kva dette er. Broussard definerer algoritme som «ein utrekningsmåte for å utleie eit resultat»,(4) eller «ein serie av steg eller prosedyrar som datamaskinen er instruert til å følgje».(5) Dette er vanlegvis automatiserte oppgåver som kan forandrast i høve til nye data; algoritmen kan gjere dei automatiserte rutinane sine betre på bakgrunn av nye data. Det er mange ulike former for maskinlæring, men Broussard held fast ved at eit felles kjenneteikn er at: «Maskinlæring handlar om å finne nokon eigenskapar ved eit datasett og så å bruke dei på nye data».(6) Ein vanleg framgangsmåte er å dele eit datasett i to delar: Den første delen blir brukt til statistisk analyse – dette blir gjerne omtala som «treningsdata». Den andre delen av datasettet blir brukt til å teste kvaliteten på den modellen ein har utvikla på desse treningsdata.

«Kunstig intelligens er animisme

Matteo Pasquinelli

for samfunn med elektrisitet»

For å vise det konkrete i denne framgangsmåten så har Broussard ein nøye gjennomgang av ein analyse av eit datasett over 1309 passasjerar på skipet Titanic i 1912.(7) Datasettet har ulike former for informasjon om kvar passasjer: Identifikasjonsnummer, namn, kjønn, alder, om dei hadde familie om bord, passasjerklasse, billettnummer, billettpris, lugarnummer og om kva hamn dei hadde gått om bord (Southampton, Cherbourg eller Queenstown). Det Broussard ville finne ut var kva faktorar som var viktigast for å kunne predikere kven av passasjerane som overlevde havariet. For å finne ut av dette brukte ho ein veldig vanleg læringsalgoritme som blir kalla «beslutningstre» (decision tree). På grunn av regelen om «kvinner og barn først» var det mange fleire kvinner og barn som overlevde sett i høve til menn, men kva andre faktorar var involverte? For å kunne gjere analysen tok Broussard dei første 891 passasjerane som sitt treningssett og let dei 418 siste fungere som testdata. Berre variablane passasjerklasse, kjønn, alder og billettpris var brukbare for analysen og ho fann at med desse fire variablane kunne ho predikere med 97% tryggleik utfallet i test-settet. Den viktigaste faktoren for overleving var billettpris: Dess meir du betalte for billetten, dess høgare sjanse for overleving(8).

Billettpris er, sjølvsagt, berre ein indikator for sosial klasse og dei som lagar algoritmar er nøydde til å bruke slike indikatorar som omset noko frå ein kvalitativ situasjon til eit kvantitativt mål. I tillegg, så manglar det også ein del opplysningar om dei som kjøpte dei billegaste billettane. Trass i det gode resultatet, så insisterer Broussard på at data-analysen hennar ikkje kan seie oss mykje om korleis dramaet om bord i Titanic spelte seg ut i det verkelege livet. Til dømes, prinsippet om «kvinner og barn først» blei tolka ulikt av dei ulike offiserane som styrte ombordstiginga i livbåtane, og praksisen blei ulik alt etter kva side på båten ein var. Måten passasjerane handterte den eksistensielle faren ved å ende opp i det iskalde vatnet, varierte frå person til person. Variablane i data-analysen er berre kvasi-årsaker og ikkje dei verkelege årsakene til død eller overleving:(9) At eit forhold opptrer samtidig med eit anna er ikkje det same som årsak. Likevel, ein prediksjon på 97 prosent er sjølvsagt imponerande, men ein modell er berre så god som den prediksjonen han kan gje utanfor dei data du alt har. Med andre ord, i kva grad kan erfaringa frå Titanic bli generaliserte? Ein rein matematisk prediksjon vil kunne vere at rike folk oftare overlever katastrofar til sjøs enn fattige. Altså, ein kan krevje høgare forsikring frå dei fattige og mindre frå dei rike.(10) Dette er logikken som ligg bak pris-optimering, der prisen for bilforsikring varierer i høve til postnummeret ditt. Dersom du lever i eit nabolag med meir kriminalitet enn gjennomsnittet, så vil forsikringsselskapa kanskje krevje høgare premie. Dei kan gjere det fordi dei vel å gjere det og vanlegvis vil dei halde deg uvitande om dei data dei brukar for å gjere det. Verknaden vil vere ei prisdiskriminering av dei underprivilegerte.

Matematisk Overvaking

Cathy O’Neil(11) legg nettopp vekt på korleis dei som lagar læringsalgoritmane, medvite eller umedvite, legg inn slagsider (bias) i vektinga av dei ulike indikatorane som ein legg inn i utrekningane. Det er viktig å vere kritisk til denne forma for data-analyse, meiner ho, for dette er den nye måten å styre og regulere dei store folkemassane i moderne samfunn. Medan ein tidlegare laga seg byråkratiske reglar, så lagar ein seg no dynamiske modellar som plukkar ut søkjarar til jobbar, avgjer kven som får lån eller livsforsikring og om ein får strengare straff som vaneforbrytar eller liknande. Tilsynelatande er algoritmane nøytrale, men dei er eigentleg «synspunkt lagt inn i matematikk».(12)

I Europa er truleg bruken av læringsalgoritmar på sosialt kjenslevare tema mindre etablert enn i USA, der O’Neil hentar dei fleste eksempla sine frå. Det er også vanskeleg å få oversikt over omfanget av denne bruken, men ein undersøking frå Universitetet i Cardiff har kasta noko lys over dette i Storbritannia.(13) I nokre britiske kommunar brukar politiet og sosialtenestane denne forma for data-analyse. Eit case dei undersøkte var Bristol Integrated Analytical Hub som integrerte alle slag sosiale data som kommunens ulike verksemder samla inn om familiane i byen. Målet var, mellom anna, tidleg intervensjon med ein sosialarbeidar dersom det var mistanke om seksuelt misbruk av barn. Datasenteret hadde bygd ein statistisk modell basert på historiske data, over familiar med seksuelt misbruk. Dersom eit barn skulka skulen, så fekk det eit visst poeng for auka risiko for seksuelt misbruk. Sameleis om det var andre forhold rundt familien og barnets åtferd som gjorde at det statistisk sett likna på måten seksuelt misbrukte barn oppfører seg.(14) Dei som arbeidde ved dette datasenteret var fullt klar over vanskane med å tolke desse data og berre ein sosialarbeidar vil kunne ha full kontekstuell kunnskap om kvart case. Ein del av dei data dei la inn i modellen kunne også ha manglar, for eksempel om barnet hadde vore i politiets søkelys på nokon måte, og det var også kommunale tenester som ikkje ville dele data med senteret.

Denne datainnsamlinga råkar sjølvsagt familiar med andre sosiale vanskar og i ein situasjon med krav om innsparing på sosiale tenester, så vil ein lett kunne tenke seg at inngrep i familien vil kunne bli utførte på bakgrunn av algoritmen. Dette vil kunne gje framtidige familietragediar. I tillegg vil det kunne inngå i ei forsterka overvaking av heile by-område og av sosiale minoritetar. Andre etatar samlar også sine data: Cardiff-rapporten nemner at enkelte politi-styrkar samlar opplysningar om tidlegare straffedømde, medan andre kjøper data om folkesetnaden frå firma som driv marknadsanalyse. Dette gjer det mogleg for politiet å identifisere geografiske problemområde i byane, og endå til enkeltadresser. Fokuset på geografiske område som «hotspots» for kriminalitet har også vore sentralt i det franske gendarmeriet sidan 2015, der dei har utvikla ein nasjonal database for å identifisere område der visse former for brotsverk mest truleg kan finne stad.(15) Tilsvarande geografiske algoritmar har ein utvikla i USA på bakgrunn av erfaringar frå okkupasjonen av Irak.(16) Geografisk profilering av folkesetnaden erstattar såleis den vanlege profileringa basert på hudfarge eller andre ytre kjenneteikn. Ein verknad av denne auka overvakinga er truleg at sosiale stigma blir forsterka og eit ekstremt utfall kan vere at ein får eit «Minority Report-samfunn» der borgarar blir arresterte på bakgrunn av ein risikofaktor kalkulert av ein algoritme, sjølv om dei ikkje har gjort noko brotsverk.

Slagsider

Det som er motivasjonen for å innføre læringsalgoritmar, både i privat og offentleg sektor, er vanlegvis å redusere kostnadane ved å handtere store mengder menneske. Algoritmane kan gå gjennom store mengder opplysningar på kort tid. Det er ikkje noko poeng å bruke dei på få personar, for kostnadane med å utvikle dei er store. Dess fleire ein kan putte inn i systemet, dess sterkare innsparing.(17) Eit av O’Neils viktigaste tema er den slagsida som vil oppstå på bakgrunn av ynska til dei som betalar for ein algoritme, på bakgrunn av dei data algoritmen er trent på og på grunn av umedvitne føresetnader hjå dataingeniørane. Eksempel på slike slagsider er at svarte tiltalte ved enkelte rettsinstansar i USA, har fått strengare straffer enn kvite på grunn av at ein algoritme har identifisert dei som framtidige vanekriminelle. Ein språkleg test for nevrologiske lidingar, utvikla i Canada, fungerte berre med folk som hadde engelsk som morsmål. Ein Google-app for attkjenning av ansikt klassifiserte afrikansk-amerikanarar som «gorillaer»(18) og ein algoritme utvikla av Amazon for å sortere søkjarar, valde bort kvinnelege dataingeniørar som «uvanlege».(19(

Ein kan sjølvsagt seie at dette kjem av at kunstig intelligens er enno i sin barndom, men ein like truleg hypotese er at problemet vil bli sterkare på grunn av det som ein kallar «forsterkande læring» (reinforcement learning) der algoritmen hentar data inn frå omgjevnadane. Dermed har ein ikkje full kontroll på kva data algoritmen trenar seg på. Eit eksempel er prate-roboten Tay på Twitter, lansert av Microsoft i mars 2016. Tay skulle svare på spørsmål frå brukarane på Twitter og kommentere ting på same vis som einkvar annan nord-amerikansk 21-åring. På mindre enn 24-timar blei Tay omdanna til ein sexistisk rasist som ville sende jødane til gasskammera og oppmoda til rasekrig mot dei svarte. Grunnen til at dette hende, var at Tay lærte frå andre brukarar av Twitter kva det kunne vere legitimt å uttrykke og mange gjekk inn for å spele Microsoft eit puss. Etter at dette hende, kopla Microsoft Tay frå nettet.(20) Medan IT-bransjen gjerne har ein tendens til å seie at Tay ikkje hadde nok data til å utvikle ei god forståing av omgjevnadane sine, så viser dette eksemplet problemet med denne forma for læring der algoritmen ikkje veit korleis han skal filtrere dei data han får inn. Og, ikkje minst, algoritmen kan ikkje utvikle ein forståing utan hjelp frå menneske.

Noter

1) Jf. Kenan Malik, «What’s Wrong With AI? Try Asking a Human Being,» The Guardian, 14. oktober 2018. James Vincent, «Twitter Taught Microsoft’s AI Chatbot to Be a Racist Asshole in Less Than a Day,» The Verge, 24. mars 2016.

2) Meredith Broussard, Artificial Unintelligence: How Computers Misunderstand the World, Cambridge, Mass.: The MIT Press, 2018.

3) Cathy O’Neil, Weapons of Math Destruction: How Big Data Increases Inequalities and Threatens Democracy, London: Penguin, 2016

4) Broussard, 7, mi oms.

5) Ibid., 94, mi oms.

6) Ibid., 93, mi oms.

7) Det var over 2000 passasjerar ombord, så det må vere nokon som ein manglar opplysningar for også.

8) Broussard, 97-114.

9) Ibid., 116-118.

10) Ibid., 114-115.

11) O’Neil, Weapons of Math Destruction.

12) Ibid., 21.

13) Lina Dencik, Arne Hintz, Joanna Redden og Harry Warne, Data Scores as Governance: Investigating uses of citizen scoring in public services, Cardiff: Data Justice Lab, Cardiff University, 2018.

14) Ibid., 28-34.

15) Alexandre Léchenet, «La gendarmerie ne parvient toujours pas à prédire l’avenir,» Mediapart, 2. september 2019.

16) Yasha Levine, Surveillance Valley: The Secret Military Histori of the Internet, London: Icon Books Ltd., 2018, 165-167.

17) O’Neil, 31.

18) Jf. Malik, «What’s wrong with AI?»

19) Reuters, «Amazon Ditched AI Recruiting Tool That Favored Men for Technical Jobs», The Guardian, 11. oktober 2018.

20) Jf. Vincent, «Twitter taught…»